Globant participó este año en la Pycon 2020 en la ciudad de Medellín, Colombia. Fueron 3 días dedicados a todos los amantes del lenguaje de programación Python.

El evento consistió de diferentes charlas y actividades, además propició un lugar de networking entre desarrolladores, compañías y clientes.

Como parte de Pycon, Globant presentó 3 experiencias digitales en el stand, 3 workshops y una presentación de la compañía, las cuales permitieron a los asistentes descubrir cómo Python y IA son usados dentro de Globant.

Acá les contamos brevemente cómo fue el evento:

Las experiencias tecnológicas

Entre las experiencias presentadas en el stand, se encuentra Globant Minds, una aplicación interactiva cuyo principal objetivo es enseñar las capacidades de Globant en el campo de visión artificial.

Globant Minds presentó a los asistentes múltiples aplicaciones de AI en imágenes como detección de rostros, clasificación de gestos y transferencia de estilos.

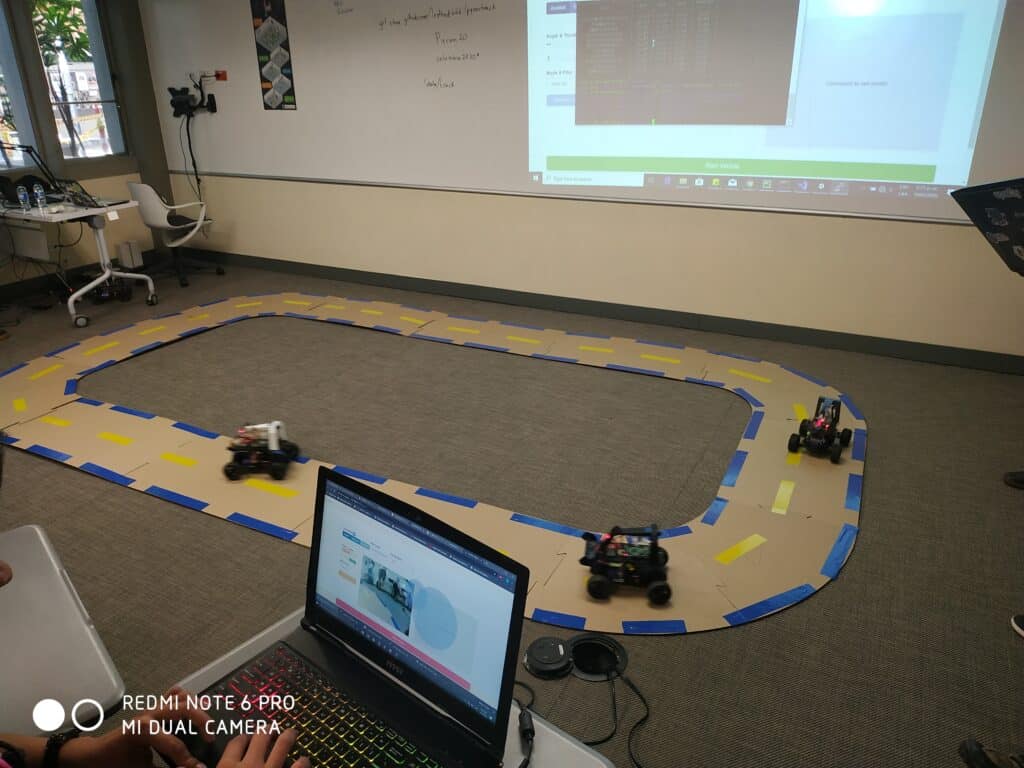

También, en el campo de la conducción autónoma, Globant mostró un modelo funcional de un vehículo autónomo a escala.

El vehículo, conocido como Donkey Car, fue presentado en el stand enseñando las particularidades en el desarrollo, prueba e implementación de software en un ambiente controlado.

Por último, como parte de las experiencias digitales Globant presentó Augmented Coding, una de las iniciativas internas enfocadas a aumentar las capacidades de los Globers por medio de AI.

Augmented Coding en particular busca facilitar el proceso de desarrollo de software mediante herramientas como la documentación automática y la búsqueda semántica de código.

Para más información acerca del potencial de estas tecnologías para transformar las organizaciones pueden visitar Augmented Globant.

Los workshops

En uno de los workshops, consideraron el Procesamiento y Análisis de Datos con Apache Spark. Ahí los participantes pudieron familiarizarse con el uso de este framework y su diverso conjunto de APIs. Los mismos pueden ser usadas desde Python, para trabajar con grandes volúmenes de datos, realizar hallazgos y calcular métricas.

Este comenzó con una breve explicación del paradigma MapReduce y Hadoop. Luego se les explicó a los participantes, la importancia de Spark, sus ventajas, su arquitectura. También se habló de su uso amplio en el mundo de Big Data.

Igualemente, se les mostró a profundidad el uso de Spark. Spark se usa para procesar y realizar variadas consultas sobre conjuntos de datos reales (preparados especialmente para el workshop).

En el workshop de Reconocimiento Facial, los participantes pudieron explorar esta área. Construyeron un pipeline que abarca desde el registro del usuario hasta su autenticación.

Consideraron un modelo de machine learning hecho a la medida, con implementación on-premise. También consideraron un prototipo cloud a través de los modelos disponibles en Amazon AWS y Microsoft Azure.

Si quieres saber un poco más sobre nuestra forma de trabajar puedes visitarnos aquí.